Editor en La Ecuación Digital. Analista y divulgador tecnológico con…

La estrategia cuántica de IBM entra en un periodo decisivo con la presentación de dos procesadores experimentales, nuevos métodos de corrección de errores y avances en software que apuntan a una mayor estabilidad operativa. La compañía sostiene que estas piezas convergerán en dos hitos que la industria sigue de cerca: la ventaja cuántica verificable a finales de 2026 y la computación tolerante a fallos en 2029. El anuncio se produjo durante la Quantum Developer Conference, celebrada el 13 de noviembre en Nueva York, donde IBM detalló una hoja de ruta que combina desarrollo tecnológico, producción industrial y experimentación abierta.

En el corazón de este enfoque se sitúa IBM Quantum Nighthawk, un procesador que aspira a ejecutar circuitos con un 30 por ciento más de complejidad que su predecesor. Los responsables de la compañía lo describen como una arquitectura pensada para operar en un rango problemático para los métodos clásicos de simulación, aunque el reto no reside solo en aumentar el número de qubits, sino en sostener tasas de error lo bastante bajas como para que el cálculo mantenga significado físico. Jay Gambetta, director de IBM Research, resume esa tensión con una frase directa: “Existen muchos elementos fundamentales que deben unirse para hacer realidad una computación cuántica verdaderamente útil”.

Según los datos proporcionados por la compañía, Nighthawk incorpora 120 qubits conectados mediante 218 acopladores sintonizables de nueva generación, organizados en una malla cuadrada donde cada qubit enlaza con otros cuatro. Esta topología supone un avance respecto al procesador IBM Quantum Heron, que servirá como punto de comparación para medir el incremento real de complejidad. La cifra de 5.000 puertas de dos qubits por circuito representa la capacidad base del procesador, aunque IBM anticipa ampliaciones rápidas, primero a 7.500 puertas en 2026 y más adelante a 10.000 en 2027. Lo llamativo es la previsión para 2028, donde la compañía describe arquitecturas con más de 1.000 qubits y acopladores de largo alcance, ya demostrados en prototipos experimentales.

Junto al despliegue del hardware, IBM pretende sostener una validación independiente que permita determinar cuándo se alcanza un caso de ventaja cuántica verificable. Para ello ha impulsado, junto a Algorithmiq, Flatiron Institute y BlueQubit, un rastreador comunitario abierto donde se documentan experimentos de estimación de observables, métodos variacionales y problemas con verificación clásica eficiente. Los investigadores de Algorithmiq subrayan la importancia de explorar regímenes que empiezan a desafiar la simulación convencional. “Estamos observando resultados experimentales prometedores”, afirma Sabrina Maniscalco. En paralelo, BlueQubit participa con experimentos basados en circuitos peaked que, según su CTO Hayk Tepanyan, permiten identificar escenarios donde los ordenadores cuánticos comienzan a superar a los clásicos por órdenes de magnitud.

Este repositorio abierto introduce un matiz relevante: la verificación no depende solo del rendimiento del hardware cuántico, sino de la solidez de los mejores métodos clásicos disponibles. Algo que añade complejidad al objetivo de demostrar ventaja cuántica, ya que las mejoras en simulación clásica pueden desplazar continuamente la frontera. IBM parece asumir ese riesgo en su estrategia, que se apoya en un ecosistema de investigación distribuido y en capacidades HPC incorporadas en su stack de software.

El software cuántico es, de hecho, el otro frente en el que IBM impulsa cambios significativos. La compañía anunció mejoras en Qiskit que amplían el uso de circuitos dinámicos y su integración con computación de alto rendimiento. Según sus estimaciones internas, estas técnicas permiten un aumento del 24 por ciento en precisión a escalas superiores a los 100 qubits. También introducen un modelo de ejecución con C-API que habilita mitigación de errores acelerada por HPC y reduce más de cien veces el coste de obtener resultados fiables.

La expansión del stack continúa con una interfaz C++ para Qiskit diseñada para integrarse en entornos científicos existentes. Esta decisión refleja un patrón cada vez más visible: la computación cuántica se aproxima a la ciencia computacional de alto rendimiento y abandona la idea de una plataforma independiente. IBM planea añadir bibliotecas de aprendizaje automático y optimización en 2027, con especial atención a la resolución de ecuaciones diferenciales y a la simulación de Hamiltonianos, dos áreas donde la física y la química computacional demandan nuevas herramientas. Es una apuesta por técnicas híbridas que, en muchos casos, mantienen el cálculo clásico como elemento central del pipeline.

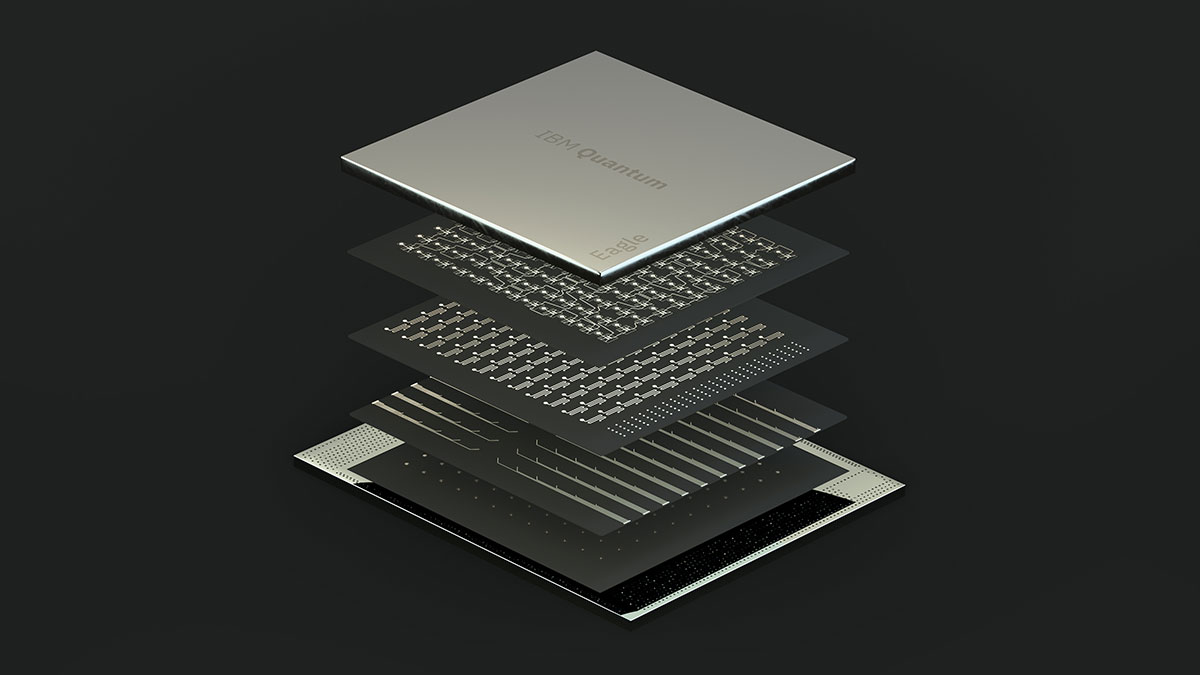

Si Nighthawk simboliza la fase previa a la ventaja cuántica, IBM Quantum Loon encarna la dirección hacia la tolerancia a fallos. La compañía lo presenta como un procesador experimental que reúne todos los componentes considerados necesarios para una arquitectura de corrección de errores práctica. Incluye múltiples capas de enrutamiento de baja pérdida que habilitan conexiones largas dentro del chip mediante c-couplers, lo que facilita enlazar qubits distantes con pérdidas reducidas. También incorpora mecanismos para reiniciar qubits entre ciclos de cálculo, un requisito operativo para aplicar códigos de corrección sostenidos.

Para que esta arquitectura cobre sentido, el procesador necesita decodificar errores en tiempo real. IBM afirma haberlo conseguido con códigos qLDPC en menos de 480 nanosegundos, una cifra que adelanta en un año los objetivos iniciales. La reducción del tiempo de decodificación es un factor crítico porque condiciona la velocidad a la que un sistema tolerante a fallos puede operar sin acumular ruido residual. Si este rendimiento se sostiene en prototipos posteriores, la compañía establecería una base técnica sobre la que escalar su propuesta de corrección de errores. Aunque a menudo se pasa por alto, la decodificación es uno de los cuellos de botella menos visibles de la computación cuántica actual.

El tercer pilar del anuncio se encuentra en la fabricación. IBM ha trasladado la producción principal de sus obleas de procesadores cuánticos a una planta de 300 mm del Albany NanoTech Complex, algo que la compañía describe como un salto necesario para acelerar el ciclo de aprendizaje. Esta decisión no solo incrementa la capacidad industrial, sino que permite procesar múltiples diseños en paralelo. Según los datos compartidos, el cambio ha duplicado la velocidad de investigación y desarrollo y ha multiplicado por diez la complejidad física de los chips que pueden fabricarse. Aunque los procesadores cuánticos todavía se encuentran lejos de los volúmenes característicos de la industria CMOS, el acceso a herramientas litográficas de última generación introduce una dinámica de iteración que el sector considera casi imprescindible para alcanzar escalabilidad real.

La convergencia de estos elementos sugiere un periodo intenso para el ecosistema cuántico. El debate no gira únicamente en torno a las fechas anunciadas, sino a la capacidad de mantener una trayectoria de mejora sostenida en hardware, software y fabricación. El ritmo de reducción de errores y el avance de la simulación clásica serán factores determinantes para medir la distancia real hacia la ventaja cuántica y la tolerancia a fallos. Los próximos dos años servirán para observar si la arquitectura planteada por IBM puede estabilizarse antes de entrar en una fase de despliegue más amplio.

Editor en La Ecuación Digital. Analista y divulgador tecnológico con más de 30 años de experiencia en el estudio del impacto de la tecnología en la empresa y la economía.