La idea de que Europa llega tarde a la carrera de la inteligencia artificial se repite con frecuencia entre empresas tecnológicas. Sin embargo, la intervención de Stefan Wrobel, profesor de la Universidad de Bonn y director del Fraunhofer IAIS, en el Gaia-X Summit 2025 de Oporto, introdujo un matiz relevante.

Recordó que el continente posee un recurso que apenas se ha explotado en el debate público: los datos industriales. Esa materia prima, dispersa en fábricas, sistemas energéticos o procesos logísticos, podría definir la próxima etapa de modelos especializados, conocidos como IA vertical, un ámbito donde Europa cuenta con una ventaja que no es trivial.

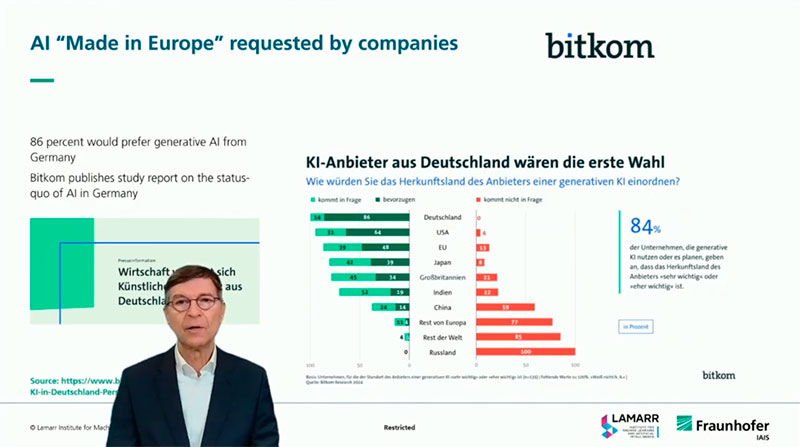

Wrobel señaló que, pese al dominio internacional de unas pocas plataformas, el tejido empresarial europeo quiere alternativas. Citó estudios realizados en Alemania: un 84 por ciento de las compañías que ya utilizan IA generativa preferiría proveedores europeos si existieran opciones viables. La cifra revela una tensión latente. Aunque el mercado global parece saturado, la dependencia tecnológica se ha vuelto demasiado visible, especialmente en sectores donde los datos no pueden salir del perímetro corporativo.

A esta situación se suma otro factor que suele pasar desapercibido. La mayor parte de los modelos actuales se entrena con contenido público. Varias proyecciones apuntan a que esa fuente se agotará pronto. Algunas sitúan ese horizonte en 2026. Cuando ocurra, explicó Wrobel, no será posible seguir ampliando modelos generalistas como hasta ahora. La atención se desplazará hacia datos industriales y sectoriales, mucho más escasos y heterogéneos. Y es ahí donde Europa puede ofrecer algo distinto.

Cuando la IA vertical se cruza con la estructura industrial europea

El profesor insistió en que esta situación abre un espacio de oportunidad que no depende solo de investigación. Requiere reformular cómo se gestionan los datos y cómo se coordinan los recursos a escala continental. La industria europea genera información de gran valor para entrenar modelos específicos: mantenimiento predictivo, verificación documental, control de procesos o análisis financiero. Pero esa información no está en la web, y esa ausencia, lejos de ser un problema, podría convertirse en un factor diferencial.

Aquí aparece el papel de Gaia-X y los espacios de datos sectoriales, cuyo objetivo es facilitar un intercambio regulado y estandarizado de datos entre empresas sin comprometer la soberanía corporativa. Para Wrobel, estas arquitecturas permiten construir una cadena de valor técnica que empieza en la disponibilidad del dato y termina en modelos verticales que respondan a necesidades muy concretas de la industria.

Política, datos y computación: el triángulo que falta por cerrar

El investigador mostró una cierta preocupación por la complejidad regulatoria. Recordó que tanto Francia como Alemania han pedido simplificar el acceso a capital y acelerar la creación de marcos que permitan usar datos industriales en desarrollos de IA. Lo dijo de forma directa: sin un entorno normativo que favorezca la agregación y circulación controlada de datos, la estrategia de IA europea avanzará con fricción.

La Comisión Europea, añadió, ha dado algunos pasos en esa dirección. El paquete de simplificación digital presentado esta semana busca aliviar cargas normativas y retrasar, con ajustes, la entrada en vigor de determinadas obligaciones. Falta comprobar si este movimiento será suficiente para acompañar la ambición técnica del sector.

Una comunidad técnica que se coordina

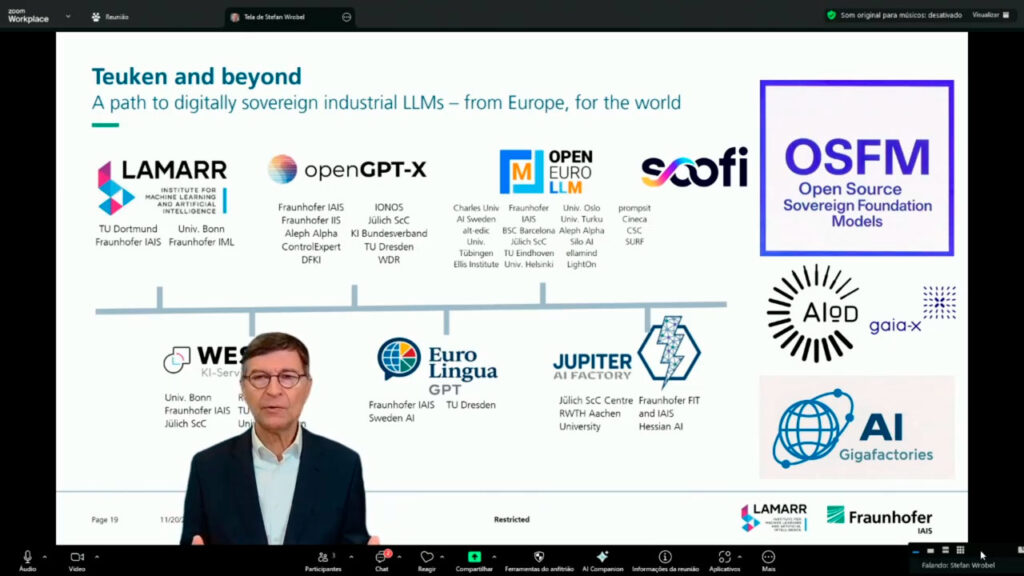

En su intervención, Wrobel también situó este debate dentro de un ecosistema europeo que empieza a mostrar una coordinación poco habitual. Mencionó iniciativas como OpenGPT-X, OpenEuroLLM, EuroLingua GPT o WestAI, que actúan como consorcios para entrenar modelos fundacionales y compartir infraestructura técnica. A ellas se suma OSFM, una alianza orientada al desarrollo de modelos soberanos en código abierto, junto con la AI-on-Demand Platform, que intenta ordenar un paisaje de proyectos dispersos y facilitar su reutilización por parte de empresas y centros de investigación.

Este entramado técnico se cruza con arquitecturas de datos como Gaia-X y con la futura red de AI Gigafactories, concebida para dotar al continente de capacidad de cómputo suficiente para entrenar modelos industriales de última generación. Aunque estas iniciativas responden a lógicas distintas, el profesor subrayó que todas confluyen en una misma dirección: evitar que Europa quede relegada al papel de consumidora de modelos externos y asegurar que el continente participe en el diseño de estándares y capacidades propias.

El vínculo entre investigación y verticales

Wrobel dedicó parte de la charla a explicar por qué el desarrollo de verticales depende de mantener la capacidad europea de entrenar modelos fundacionales. Aunque la industria parece inclinarse hacia el ajuste fino de modelos existentes, advirtió que sin un modelo base propio no es posible garantizar la calidad, la seguridad ni el control sobre los datos utilizados.

El trabajo del Fraunhofer IAIS y del Lamarr Institute sirve como ejemplo. En los últimos tres años, han construido una infraestructura que combina ingeniería de datos, acceso a computación distribuida y técnicas de entrenamiento a gran escala. A finales de 2024 lanzaron un modelo de 7.000 millones de parámetros como prueba de esta capacidad. Y continúan entrenando versiones más potentes que sirvan de base para nuevos verticales.

Como muestra de aplicación, presentó un modelo diseñado para auditoría financiera. La herramienta, derivada del modelo fundacional interno, reduce casi a la mitad el tiempo necesario para revisar listas y documentos contables. Lo interesante no es la reducción de tiempos, sino lo que implica: el salto de un modelo general a un vertical operativo exige control total del preentrenamiento y colaboración con empresas que conocen el dominio.

Un camino que exige coordinación

El cierre de la intervención dejó una advertencia. Europa dispone de piezas técnicas y políticas que podrían sostener una estrategia sólida de IA vertical, pero su impacto dependerá de la capacidad de coordinar recursos y evitar que los esfuerzos se dispersen. Si se aprovechan las AI Gigafactories, si los data spaces conectan con la investigación y si las redes abiertas como OSFM crecen, el continente podría ocupar un nicho global basado en modelos industriales difíciles de replicar desde otros entornos.

La pregunta no es si Europa puede hacerlo, sino si será capaz de sincronizar la política, la industria y la investigación a tiempo. Wrobel insistió en que la comunidad científica está preparada y que la industria muestra voluntad de adoptar alternativas europeas. Falta comprobar si la política acompañará con la misma determinación.