La frontera entre lo real y lo simulado será cada vez más difícil de distinguir en 2026. Así lo anticipa el informe Kaspersky Security Bulletin 2025. Statistics , que dibuja un escenario en el que la inteligencia artificial generativa y los deepfakes no solo se consolidan como herramientas de creación, sino también como vectores de ataque en manos del cibercrimen automatizado.

Según los analistas de Kaspersky, el desarrollo de modelos de lenguaje avanzados está teniendo un efecto dual: mientras refuerza las capacidades defensivas de los equipos de ciberseguridad, también amplifica las posibilidades ofensivas de los atacantes. La facilidad con la que hoy se pueden generar contenidos falsos, ya sean imágenes, vídeos o audios, está erosionando la confianza en los canales digitales tradicionales. Y lo más preocupante es que esta tendencia no muestra signos de desaceleración.

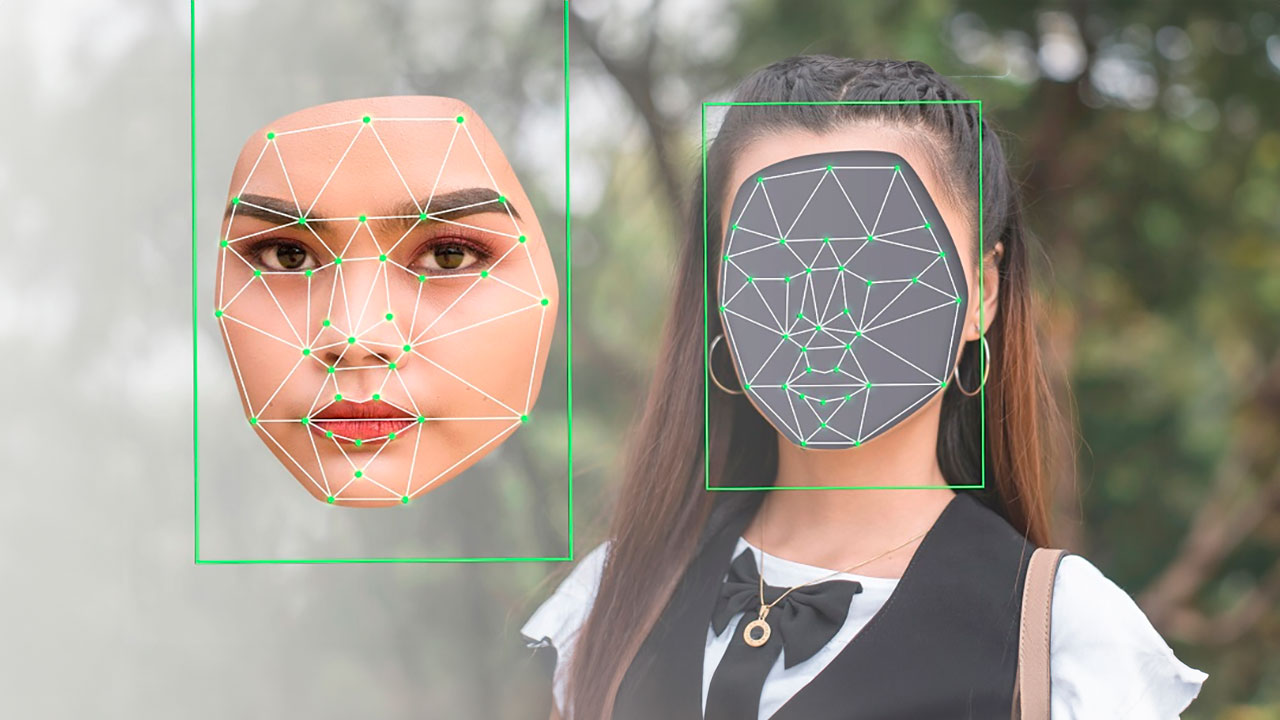

El fenómeno de los deepfakes, que hace apenas unos años se percibía como anecdótico o marginal, empieza a adquirir un peso estructural. Las empresas, conscientes del riesgo, están incorporando formación específica para que sus empleados aprendan a detectar estas manipulaciones. Pero el problema no se limita al ámbito corporativo. A nivel individual, los usuarios se enfrentan cada vez con mayor frecuencia a contenidos falsificados, lo que obliga a replantear los mecanismos de verificación y autenticidad en entornos digitales.

Uno de los focos de preocupación es la evolución de los deepfakes en tiempo real. Tecnologías que permiten alterar la voz o el rostro durante una videollamada ya están disponibles, aunque su uso aún requiere cierto nivel técnico. Sin embargo, el ritmo de mejora en la calidad del audio y la accesibilidad de estas herramientas apunta a un escenario en el que su utilización será más común y menos detectable. El uso de cámaras virtuales y software de manipulación en directo podría facilitar ataques dirigidos con un nivel de realismo sin precedentes.

En paralelo, los modelos de IA de código abierto están alcanzando niveles de rendimiento comparables a los sistemas cerrados, pero sin los mismos controles de seguridad. Esta apertura tecnológica, aunque beneficiosa para la innovación, también reduce las barreras de entrada para los actores maliciosos. El resultado es un ecosistema donde las herramientas más potentes están disponibles tanto para investigadores legítimos como para grupos criminales.

La dificultad para distinguir entre lo auténtico y lo manipulado no se limita a los contenidos visuales. Correos electrónicos falsificados, suplantación de identidad de marcas o páginas de phishing con diseño profesional forman parte del nuevo repertorio del cibercrimen. Y mientras tanto, muchas empresas están normalizando el uso de contenido generado por IA en su comunicación, lo que añade una capa más de ambigüedad al entorno digital.

Aunque los esfuerzos por etiquetar el contenido generado por IA han aumentado, la falta de estándares técnicos y normativos sólidos dificulta su eficacia. Las etiquetas actuales pueden ser eliminadas con relativa facilidad, lo que deja a los usuarios sin una referencia clara sobre la autenticidad del contenido que consumen. Kaspersky anticipa que surgirán nuevas iniciativas para abordar esta brecha, pero su impacto dependerá de la coordinación entre actores públicos y privados.

Otro aspecto que marcará el panorama de 2026 es la automatización del cibercrimen. La IA no solo se usará para generar contenido falso, sino también para optimizar cada fase de la cadena de ataque. Desde la escritura de código malicioso hasta la identificación de vulnerabilidades o el despliegue de malware, los sistemas automatizados permitirán a los atacantes operar con mayor velocidad y precisión. Además, se espera que los ciberdelincuentes intenten ocultar el uso de IA para dificultar el análisis forense y el rastreo de sus actividades.

No obstante, la misma tecnología que potencia las amenazas también refuerza las defensas. Herramientas basadas en agentes inteligentes podrán monitorizar de forma continua la infraestructura digital de una organización, detectar anomalías y ofrecer recomendaciones contextualizadas. Esto permitirá a los analistas de seguridad centrarse en la toma de decisiones estratégicas, reduciendo la carga operativa de tareas repetitivas.

Además, los sistemas de defensa adoptarán interfaces en lenguaje natural, lo que facilitará su uso por parte de profesionales no técnicos. Bastará con escribir una instrucción en lenguaje corriente para activar procesos complejos de análisis o respuesta. Esta evolución podría democratizar el acceso a capacidades avanzadas de ciberseguridad, aunque también plantea interrogantes sobre la dependencia tecnológica y la necesidad de supervisión humana.

La proyección de Kaspersky no apunta a un colapso, sino a una transformación acelerada del equilibrio entre innovación y riesgo. La clave, según sus expertos, estará en la capacidad de anticipación. Las organizaciones que logren integrar herramientas de IA de forma responsable y estratégica estarán mejor posicionadas para afrontar un entorno donde la ambigüedad, más que la certeza, será la norma.

España, como parte del ecosistema digital europeo, no es ajena a estas dinámicas. La regulación comunitaria en materia de IA y ciberseguridad, aún en fase de desarrollo, tendrá un papel decisivo en los próximos años. Pero más allá del marco normativo, será la agilidad de las empresas para adaptarse a estos cambios lo que determinará su resiliencia digital.