Editor en La Ecuación Digital. Analista y divulgador tecnológico con…

Cuando Jensen Huang subió al escenario del CES 2026 en Las Vegas, el foco no estuvo en una lista de productos ni en una sucesión de lanzamientos independientes. Su intervención sirvió para articular una idea más amplia y menos cómoda para parte del sector: la computación tradicional ha entrado en una fase de reemplazo estructural, y lo que emerge no es una nueva arquitectura aislada, sino un sistema completo, diseñado de extremo a extremo para inteligencia artificial.

El marco elegido no fue casual. El CES se ha convertido en un escaparate donde confluyen consumo, industria y tecnología profunda. En ese contexto, NVIDIA utilizó su keynote para articular una tesis que atraviesa todos sus anuncios: la IA ya no es una capa que se añade al software existente, sino la base sobre la que se construyen nuevas aplicaciones, nuevos dispositivos y, cada vez más, nuevos sectores industriales.

La plataforma Rubin como nuevo núcleo de la computación basada en IA

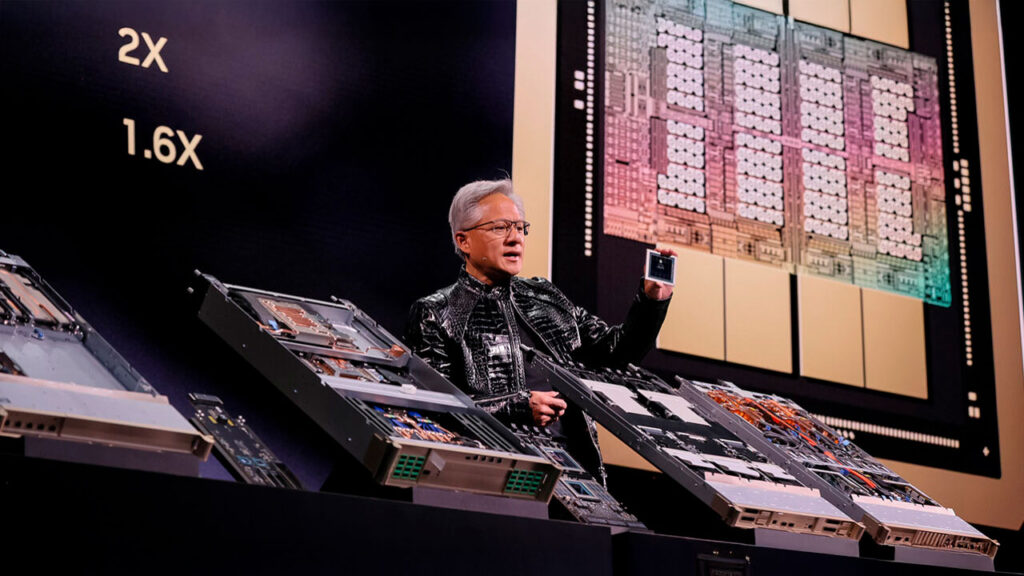

El anuncio central fue Rubin, la nueva plataforma de computación de NVIDIA y sucesora de Blackwell. No se trata solo de una nueva GPU o de un incremento de rendimiento incremental. Rubin es la primera plataforma “extreme-codesigned” de la compañía: seis chips diseñados conjuntamente, desde CPU y GPU hasta red, DPUs y almacenamiento, con el objetivo explícito de eliminar cuellos de botella que ya no son computacionales, sino sistémicos.

La lógica es clara. Los modelos de IA crecen en parámetros, pero también en complejidad operativa: razonamiento en tiempo de inferencia, agentes que encadenan tareas, contextos cada vez más largos. En ese escenario, optimizar solo el procesador deja de ser suficiente. Rubin apunta a reducir el coste por token a aproximadamente una décima parte respecto a la generación anterior, un dato que Huang repitió varias veces porque encierra una implicación económica directa: la frontera de la IA ya no se define solo por quién puede entrenar modelos más grandes, sino por quién puede hacerlo de forma sostenible.

A ese núcleo se suman elementos menos visibles pero estratégicos, como NVLink 6, Spectrum-X con fotónica integrada o BlueField-4, que redefine el papel del almacenamiento al introducir una capa de memoria de contexto pensada específicamente para inferencia de largo alcance. No es un detalle técnico: la gestión del “KV cache” se ha convertido en uno de los principales cuellos de botella para laboratorios de IA y proveedores cloud.

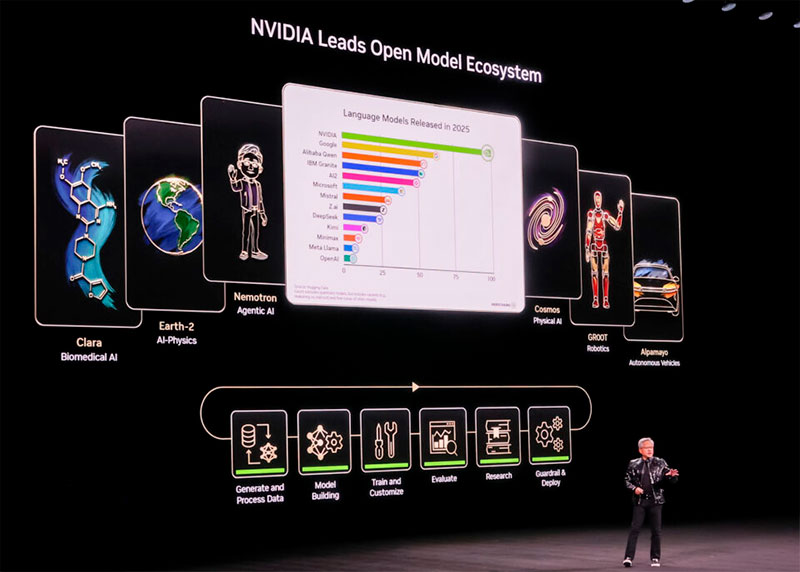

Modelos abiertos de NVIDIA: de la infraestructura al liderazgo en IA de frontera

Rubin es la base, pero no el final del mensaje. NVIDIA se presentó explícitamente como constructor de modelos de frontera, y además como uno de los principales impulsores de la apertura en IA. Su portafolio de modelos abiertos cubre seis dominios que van desde la salud (Clara) y el clima (Earth-2) hasta la robótica (Cosmos, GR00T) y la conducción autónoma (Alpamayo).

El énfasis en lo abierto no fue retórico. Huang insistió en que estos modelos no solo se publican, sino que se acompañan de datos, librerías y herramientas para gestionar todo su ciclo de vida, desde el entrenamiento hasta el despliegue con guardrails. En un momento en que parte del sector asocia “modelo de frontera” con plataformas cerradas y APIs opacas, NVIDIA intenta ocupar un espacio intermedio: infraestructura propietaria, inteligencia compartida.

La referencia al impacto de modelos abiertos como DeepSeek R1 no fue casual. Sirvió para subrayar que la innovación ya no se concentra en unos pocos actores, y que el ritmo de avance viene marcado por comunidades globales que descargan, adaptan y reentrenan modelos a una velocidad difícil de replicar con enfoques cerrados.

La IA personal y los agentes como extensión de los modelos abiertos

Otro de los ejes del discurso fue la IA personal. Frente a la narrativa dominante del hyperscale, NVIDIA mostró cómo agentes completos pueden ejecutarse localmente, combinando modelos abiertos, routing inteligente y ejecución híbrida entre cloud y edge.

El ejemplo del DGX Spark, actuando como un superordenador de escritorio, no apunta al consumidor masivo, sino a desarrolladores, investigadores y empresas que necesitan privacidad, latencia baja y control del dato. En ese contexto, la IA deja de ser solo un servicio remoto y empieza a comportarse como una infraestructura local, con implicaciones claras para sectores regulados y entornos industriales.

Las referencias a integraciones con plataformas empresariales como Palantir, ServiceNow o Snowflake refuerzan otra idea: los sistemas agenticos no son una capa más de automatización, sino la futura interfaz de usuario de los sistemas empresariales. La metáfora del formulario o la hoja de cálculo empieza a quedarse corta.

IA física, simulación y el salto del software al mundo real

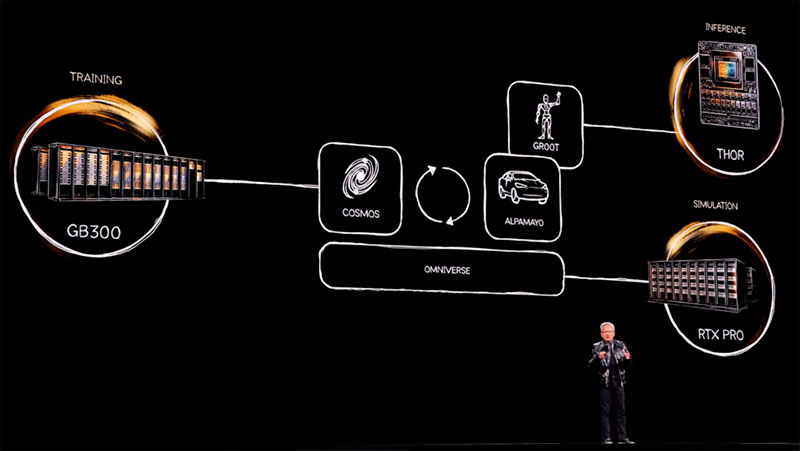

Donde el discurso ganó más peso estratégico fue en la llamada IA Física. NVIDIA lleva años invirtiendo en simulación, pero ahora la presenta como la condición necesaria para que la IA interactúe con el mundo físico de forma fiable.

Cosmos, su modelo fundacional del mundo, no se limita a generar vídeo. Actúa como motor de generación de datos sintéticos, razonamiento físico y simulación cerrada, permitiendo entrenar sistemas para escenarios raros o peligrosos sin necesidad de recorrer millones de kilómetros reales. En un momento en que la escasez de datos se convierte en el principal freno para la robótica y la autonomía, la capacidad de “convertir computación en datos” adquiere un valor estructural.

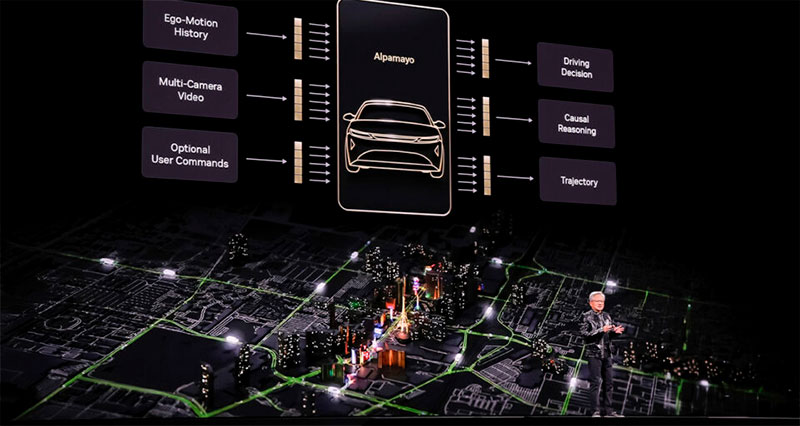

Ese enfoque converge en Alpamayo, el nuevo sistema abierto de conducción autónoma de NVIDIA. Más que un modelo, Alpamayo es un conjunto de modelos VLA, simuladores y datasets diseñados para autonomía de nivel 4, con una característica clave: el sistema no solo actúa, sino que razona y explica la acción que va a tomar.

La demostración con el Mercedes-Benz CLA, primer vehículo de producción que incorporará Alpamayo sobre la plataforma NVIDIA DRIVE, funciona como validación industrial. No es un prototipo de laboratorio, sino un coche que llegará a la carretera, primero en Estados Unidos y después en Europa, respaldado por una arquitectura con redundancia y certificación de seguridad.

La estrategia es coherente con el resto del mensaje: NVIDIA construye el stack completo, lo prueba en un caso real de alta exigencia, y después lo abre al ecosistema para que otros fabricantes adopten partes o la totalidad del sistema.

Industria y automatización: De la fábrica al gemelo digital

El cierre del keynote amplió aún más el foco. La alianza con Siemens y la integración profunda de Omniverse, CUDA-X y modelos de IA en software industrial apuntan a un escenario donde las fábricas se diseñan, simulan y optimizan como sistemas robóticos antes de existir físicamente.

Aquí aparece una de las tensiones más relevantes del discurso. Mientras la IA generativa acapara titulares en consumo y servicios, NVIDIA está posicionando la IA física y la simulación industrial como el siguiente gran mercado. No es inmediato ni sencillo, pero conecta con problemas estructurales como la escasez de mano de obra cualificada y la necesidad de automatización a gran escala.

La integración total de la IA plantea un nuevo equilibrio para el ecosistema tecnológico

El CES 2026 deja una imagen clara: NVIDIA ya no compite solo como proveedor de chips, ni siquiera como proveedor de plataformas. Como subrayó Jensen Huang en el cierre de su intervención, la compañía se posiciona ahora como arquitecto de sistemas completos para la era de la IA, desde el silicio hasta los modelos, con la ambición de ofrecer una pila tecnológica integral sobre la que el ecosistema pueda construir aplicaciones que hoy todavía no existen. Ese enfoque atraviesa el centro de datos, pero también el coche, el robot y la fábrica.

La incógnita no es si esta visión es técnicamente viable, las demostraciones sugieren que lo es, sino cómo reaccionará el resto del ecosistema. Fabricantes, desarrolladores y reguladores tendrán que decidir hasta qué punto adoptan stacks cada vez más integrados frente a alternativas más fragmentadas. Esa elección, más que cualquier benchmark, es la que probablemente marcará el próximo ciclo de la computación.

Editor en La Ecuación Digital. Analista y divulgador tecnológico con más de 30 años de experiencia en el estudio del impacto de la tecnología en la empresa y la economía.