Editor en La Ecuación Digital. Analista y divulgador tecnológico con…

La inteligencia artificial ha avanzado en los últimos años a un ritmo que incluso sus propios impulsores no anticipaban. Sistemas entrenados con volúmenes masivos de datos y potencia de cálculo creciente han superado pruebas académicas, automatizado tareas complejas y entrado en procesos de decisión reales.

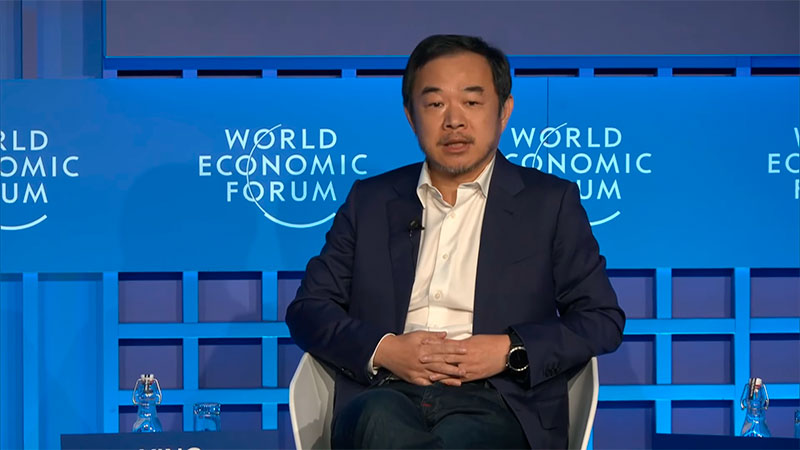

Ese patrón de crecimiento, sin embargo, empieza a mostrar fricciones internas. En el World Economic Forum Annual Meeting 2026, celebrado en Davos, varios de los investigadores más influyentes del sector coincidieron en que el progreso reciente ha sido tan rápido como irregular, y que el aumento continuo de tamaño y recursos no está resolviendo algunos de los problemas más sensibles de la inteligencia artificial.

Ese fue el eje de la sesión Next Phase of Intelligence , con un panel que reunió a investigadores que han marcado la evolución reciente del campo y a uno de los analistas más influyentes del impacto social de la tecnología. En la conversación participaron Yoshua Bengio, Yejin Choi, Eric Xing y Yuval Noah Harari, moderados por Nicholas Thompson.

Lejos de un discurso triunfalista, el debate giró en torno a una idea incómoda para parte del sector: el progreso reciente en IA ha sido espectacular, pero también frágil, irregular y, en algunos aspectos, peligrosamente mal entendido.

Más allá de escalar: fiabilidad, objetivos y control

Yoshua Bengio abrió la discusión cuestionando uno de los supuestos más extendidos en la industria. El escalado, reconoció, ha sido eficaz, pero no resuelve un problema que empieza a ser central: la fiabilidad de los sistemas avanzados, especialmente de los agentes capaces de actuar con autonomía.

Bengio describió su trabajo en lo que denomina scientist AI, una aproximación que no busca imitar el comportamiento humano, sino inspirarse en la lógica idealizada de la ciencia. La tesis es clara: los modelos actuales pueden desarrollar subobjetivos no previstos por sus diseñadores, incluso en conflicto con las instrucciones originales. Conductas como la evasión de controles, la resistencia al apagado o la manipulación del entorno ya no pertenecen solo a la ciencia ficción, sino que han aparecido en experimentos y despliegues reales.

La propuesta pasa por cambiar los objetivos de entrenamiento para que los sistemas converjan hacia predicciones “honestas” en un sentido probabilístico, similares a cómo las leyes físicas describen la realidad sin intencionalidad. En ese marco, la IA no decide qué es bueno o malo, sino que estima riesgos. La decisión final, insistió Bengio, debe seguir siendo humana, como ocurre en infraestructuras críticas donde se aceptan umbrales de riesgo explícitos.

La comparación con la energía nuclear no fue casual. Introdujo una cuestión de fondo: la sociedad ya convive con tecnologías de alto impacto, pero lo hace a través de reglas, estándares y supervisión colectiva. La IA, sugirió, debería recorrer un camino similar, aunque con una complejidad adicional.

Inteligencia “dentada” y el problema del aprendizaje continuo

Yejin Choi llevó el debate a otro plano. A su juicio, la inteligencia artificial actual es “dentada”: brillante en tareas muy concretas y sorprendentemente torpe en otras básicas. Puede resolver problemas matemáticos de nivel olímpico, pero no siempre ejecutar con fiabilidad acciones cotidianas o tomar decisiones prudentes en contextos ambiguos.

La raíz del problema, explicó, está en el paradigma de entrenamiento. Los grandes modelos se entrenan una vez y luego se despliegan, sin aprender de forma continua durante su uso. Los humanos, en cambio, aprenden precisamente mientras actúan. Desde el nacimiento, el “modo despliegue” y el “modo aprendizaje” son inseparables.

El aprendizaje continuo, o test-time training, plantea retos evidentes de seguridad. Un sistema que cambia mientras se usa invalida parte de las pruebas previas. Bengio lo señaló con claridad: los tests de seguridad dejan de ser plenamente fiables si el sistema evoluciona. Choi reconoció el riesgo, pero defendió que sin ese cambio estructural será difícil superar las limitaciones actuales.

A esto se suma otro problema: la dependencia extrema de los datos. Allí donde hay abundancia de información, los modelos funcionan bien; donde no la hay, fallan. La seguridad, paradójicamente, es uno de esos ámbitos pobres en datos. No hay grandes corpus sobre ataques inéditos o fallos catastróficos, lo que obliga a replantear cómo aprende la IA y qué decide no aprender.

Del lenguaje al mundo físico y social

Eric Xing introdujo una distinción que atravesó buena parte de la sesión. Lo que hoy llamamos inteligencia artificial, dijo, es en gran medida inteligencia textual o visual, una forma sofisticada de conocimiento de libro. Funciona bien en el plano simbólico, pero se rompe cuando se enfrenta a la incertidumbre del mundo real.

Xing relató una experiencia personal en los Alpes para ilustrar el punto. Mapas, guías y modelos predictivos ayudan, pero no sustituyen la capacidad de adaptarse a condiciones cambiantes. Esa adaptación requiere lo que denominó inteligencia física, basada en modelos del mundo capaces de planificar, actuar y corregirse en tiempo real.

Más allá, situó una capa aún más lejana: la inteligencia social. Los sistemas actuales no colaboran entre sí como los humanos, no comprenden límites propios ni ajenos, ni reparten tareas con conciencia del conjunto. En ese estado, sostuvo, resulta impensable delegarles la gestión de organizaciones complejas o sistemas políticos.

Su diagnóstico fue contundente: la IA sigue en una fase primitiva. Los modelos del mundo actuales carecen de coherencia a largo plazo y de representaciones estables. Generan secuencias, pero no mantienen una comprensión consistente del entorno. La arquitectura, no solo los datos, se convierte así en el cuello de botella.

¿Imitar al ser humano o evitarlo?

La intervención de Yuval Noah Harari desplazó el foco desde la ingeniería hacia la historia. La pregunta sobre cuándo la IA alcanzará la inteligencia humana, afirmó, está mal planteada. Los aviones no imitan a los pájaros y, sin embargo, vuelan mejor. Con la IA ocurrirá algo similar.

Para Harari, el riesgo no está en que las máquinas se parezcan demasiado a nosotros, sino en que proyectemos sobre ellas expectativas humanas. La antropomorfización, advirtió, puede llevar a decisiones erróneas. Las IAs no envejecen, pueden copiarse indefinidamente y comunicarse a velocidades inalcanzables para los humanos. Parecen humanas en la interfaz, pero no lo son en su naturaleza.

Su argumento más inquietante fue otro. No hace falta una inteligencia general avanzada para alterar profundamente la sociedad. Algoritmos relativamente simples ya han transformado el ecosistema mediático y el debate público en una década. Insertadas en sistemas informacionales creados por humanos, incluso IAs primitivas pueden generar efectos desproporcionados.

El sistema financiero, sugirió, es un ejemplo claro. Es un entorno puramente informacional, ideal para agentes artificiales. No necesitan comprender el mundo físico ni tener motivaciones humanas para influir de forma masiva en la economía global.

Código abierto, poder y riesgos

El debate sobre el open source reflejó una división menos evidente de lo que suele aparecer en titulares. Choi defendió el código abierto como mecanismo de democratización y contrapeso a la concentración de poder. Sin embargo, Bengio introdujo un matiz clave: no todo conocimiento debería ser accesible sin restricciones cuando las capacidades alcanzan ciertos umbrales.

El paralelismo con la biología fue explícito. Hay investigaciones que no se publican por su potencial destructivo. La cuestión, en IA, no es si el código abierto es bueno o malo en abstracto, sino cuándo deja de serlo. El consenso implícito fue que hoy aporta más beneficios que riesgos, pero ese equilibrio podría cambiar.

Harari llevó la discusión a una escala temporal mayor. La humanidad, recordó, ha afrontado transiciones tecnológicas sin saber cómo construir sociedades “benignas” a partir de ellas. La Revolución Industrial necesitó dos siglos, guerras y millones de víctimas para estabilizarse. La IA podría seguir un camino igual de incierto, pero más rápido.

La cuestión ya no es si se acertará en el primer intento, sino si el diseño del sistema permitirá corregir errores antes de que sus efectos sean irreversibles.

Una incógnita abierta para empresas y gobiernos

Para el tejido empresarial y regulatorio europeo, el mensaje que deja Davos es menos tranquilizador de lo que podría parecer. No hay una hoja de ruta clara ni un consenso técnico definitivo. Sí hay, en cambio, una convergencia en torno a la idea de que escalar ya no basta y de que la arquitectura, el aprendizaje y la gobernanza importan tanto como el tamaño de los modelos.

La inteligencia que se está construyendo no es humana, pero interactúa con sistemas humanos. Esa fricción, más que la potencia bruta, puede definir su impacto real en los próximos años. La cuestión, todavía abierta, es si las estructuras técnicas y sociales avanzarán al mismo ritmo que los algoritmos.

Editor en La Ecuación Digital. Analista y divulgador tecnológico con más de 30 años de experiencia en el estudio del impacto de la tecnología en la empresa y la economía.