Editor en La Ecuación Digital. Analista y divulgador tecnológico con…

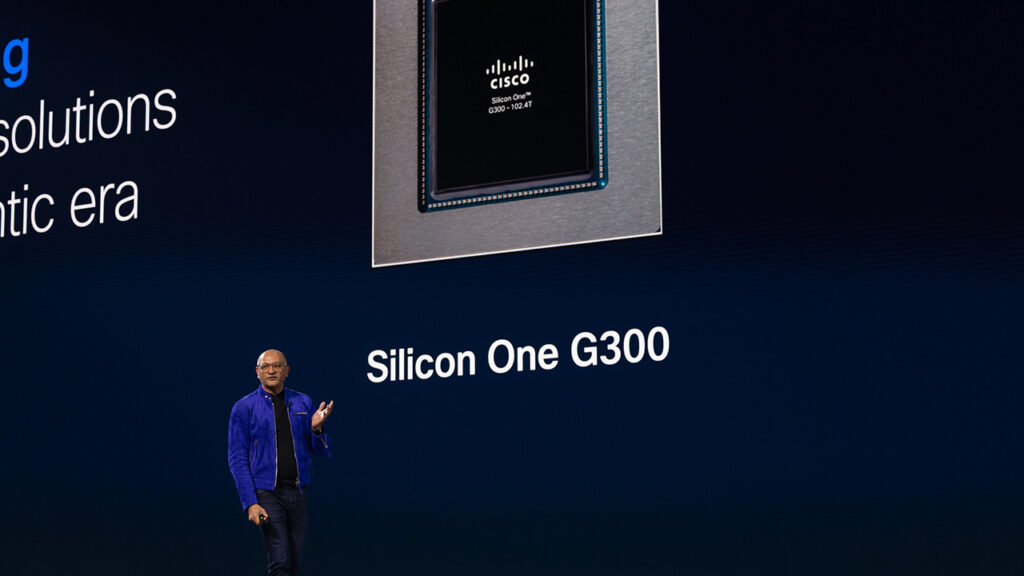

Cisco ha elegido un chip para subrayar uno de los mensajes centrales de Cisco Live EMEA 2026. Silicon One G300, con capacidad de hasta 102,4 terabits por segundo, concentra buena parte del debate sobre infraestructura que atraviesa el evento. La expansión de la inteligencia artificial está trasladando la discusión hacia los límites físicos del centro de datos.

Durante la última década, la diferenciación tecnológica se apoyó principalmente en software y servicios cloud. La industrialización de la IA está reequilibrando esa relación. A medida que los centros de datos sostienen modelos persistentes y agentes en ejecución continua, la eficiencia del silicio, la red y la refrigeración empieza a tener un impacto directo en costes, estabilidad y capacidad de crecimiento.

Cuando la red impacta directamente en el coste de la IA

Las cargas de trabajo de inteligencia artificial presentan patrones distintos a los de las aplicaciones empresariales tradicionales. Entrenamientos distribuidos, inferencias paralelas y sincronización entre miles de procesos generan tráfico irregular y picos difíciles de anticipar. En ese entorno, la latencia, la pérdida de paquetes y la variabilidad dejan de ser tolerables.

Aquí se sitúa el G300, diseñado para redes de centros de datos orientadas a IA. Más allá del ancho de banda máximo, el foco está en la estabilidad bajo condiciones extremas de tráfico y en la capacidad de absorber ráfagas sin degradar el conjunto.

Según los datos compartidos por la compañía, el chip permite mejorar hasta un 33 % la utilización de red y reducir en torno a un 28 % el tiempo de finalización de trabajos frente a arquitecturas no optimizadas. En clústeres donde cada GPU representa una inversión relevante y el consumo energético es constante, estos porcentajes influyen en el rendimiento económico del sistema.

La red deja de ser un componente neutral y pasa a formar parte del resultado productivo.

Del scale-up al scale-across

La arquitectura de centros de datos para IA ha evolucionado con rapidez. El escalado comenzó dentro de una GPU, después entre GPUs en un mismo servidor y más tarde entre racks completos. El siguiente paso consiste en conectar centros de datos separados geográficamente para que operen como un único clúster lógico.

Este modelo introduce exigencias más estrictas sobre la red. La latencia entre ubicaciones, la resiliencia ante fallos de enlace y la gestión de tráfico impredecible condicionan la viabilidad del sistema. Un microcorte puede invalidar procesos de entrenamiento que consumen grandes volúmenes de energía y tiempo de cómputo.

El diseño del G300 busca responder a esa transición. Su arquitectura está orientada a gestionar tráfico irregular, reaccionar con rapidez ante fallos y minimizar la pérdida de paquetes en entornos distribuidos. La programabilidad del silicio añade un margen adicional para adaptar su comportamiento a la evolución de los patrones de tráfico de IA.

En infraestructuras que se renuevan con ciclos más largos que el software, esa capacidad de adaptación tiene implicaciones estratégicas.

Del chip al sistema completo

El G300 se integra en nuevos sistemas de las familias Cisco N9000 y Cisco 8000, dirigidos tanto a entornos empresariales como a infraestructuras de mayor escala. Entre las novedades destaca la disponibilidad de versiones completamente refrigeradas por líquido, junto a configuraciones tradicionales por aire.

La refrigeración se ha convertido en un factor estructural. A medida que aumenta la densidad de cómputo, la capacidad de disipar calor condiciona tanto el rendimiento como la sostenibilidad económica de los centros de datos. Los diseños líquidos permiten concentrar mayor ancho de banda en menos espacio físico y mejorar la eficiencia energética del conjunto.

La compañía señala que estas configuraciones pueden consolidar en un único sistema el ancho de banda que anteriormente requería múltiples equipos, con reducciones significativas en consumo energético en determinados escenarios. La escala, en este contexto, depende tanto de la coordinación de componentes como de su número.

Óptica, fiabilidad y sostenibilidad

El crecimiento de la inteligencia artificial está tensionando infraestructuras eléctricas y modelos de sostenibilidad. La eficiencia de la red forma parte de esa ecuación.

Las nuevas ópticas de 1,6T y los módulos lineales introducidos junto al G300 buscan reducir el consumo de los transceptores y mejorar la fiabilidad en entornos térmicamente exigentes. En trabajos de larga duración, donde los procesos pueden extenderse durante horas o días, el tiempo hasta el primer fallo se acorta a medida que aumenta la escala del clúster.

La calidad de la óptica y la gestión de congestión impactan directamente en la estabilidad del sistema. Una interrupción no supone solo una incidencia técnica, sino reinicios, retrasos y costes adicionales.

La infraestructura empieza a evaluarse por su previsibilidad operativa, no únicamente por su rendimiento máximo.

Silicio como diferenciación estratégica

Durante buena parte de la era cloud, el silicio se percibió como intercambiable. La IA está alterando esa percepción. La eficiencia del hardware, la capacidad de programación y la integración con el resto del stack influyen ahora en métricas económicas tangibles.

Controlar el diseño del silicio permite integrar inteligencia directamente en la red, optimizar el flujo de datos y anticipar escenarios de congestión. En entornos donde la productividad se mide en resultados obtenidos por unidad de energía o inversión, esa integración adquiere dimensión estratégica.

Cisco Live EMEA 2026 sitúa el debate en ese plano. El acceso a modelos avanzados resulta insuficiente si la infraestructura no puede sostenerlos de forma eficiente y estable.

Infraestructura como límite y oportunidad

La presentación de Silicon One G300 evidencia un cambio de enfoque. A medida que la inteligencia artificial se consolida como infraestructura crítica, la capa física recupera protagonismo.

La ventaja competitiva dependerá en gran medida de la capacidad de convertir modelos en resultados sostenibles. En ese equilibrio entre rendimiento, consumo energético, fiabilidad y escalabilidad se define una parte relevante del posicionamiento tecnológico de los próximos años.

En la era agéntica, la infraestructura vuelve a marcar el perímetro de crecimiento.

Editor en La Ecuación Digital. Analista y divulgador tecnológico con más de 30 años de experiencia en el estudio del impacto de la tecnología en la empresa y la economía.