Snowflake ha presentado Snowflake Arctic, un large language model (LLM) de última generación diseñado exclusivamente para ser el LLM empresarial más abierto del mercado. Con su exclusiva arquitectura de Mezcla de Expertos (MoE), Arctic ofrece inteligencia de vanguardia con una eficiencia sin precedentes a escala. Está optimizado para cargas de trabajo empresariales complejas, superando varios puntos de referencia del sector en generación de código SQL, seguimiento de instrucciones, entre otros. Además, Snowflake publica los pesos de Arctic bajo una licencia Apache 2.0 y los detalles de la investigación que condujo a cómo se entrenó, estableciendo un nuevo estándar de apertura para la tecnología de IA empresarial. El LLM Snowflake Arctic forma parte de la familia de modelos Snowflake Arctic, una familia de modelos creada por Snowflake que también incluye los mejores modelos prácticos de texto embebido para casos de uso de recuperación.

Arctic marca un hito con una colaboración verdaderamente abierta y ampliamente disponible

Según un informe reciente de Forrester, aproximadamente el 46% de los responsables de la toma de decisiones sobre IA en empresas de todo el mundo está aprovechando los LLM de código abierto existentes para adoptar la IA generativa como parte de la estrategia de IA de su organización1. Con datos fundacionales de Snowflake para más de 9.400 empresas y organizaciones de todo el mundo2, se está capacitando a todos los usuarios para aprovechar sus datos con LLM abiertos líderes en el sector, al mismo tiempo que les ofrece flexibilidad y capacidad de elección con respecto a los modelos con los que trabajan.

Ahora, con el lanzamiento de Arctic, Snowflake ofrece un modelo potente y verdaderamente abierto con una licencia Apache 2.0 que permite el uso personal, comercial y de investigación sin restricciones. Además, Snowflake proporciona plantillas de código y opciones flexibles de inferencia y formación para que los usuarios puedan empezar rápidamente a desplegar y personalizar Arctic utilizando sus entornos de trabajo preferidos. Entre ellos se incluyen NVIDIA NIM con NVIDIA TensorRT-LLM, vLLM y Hugging Face. Para su uso inmediato, Arctic está disponible para la inferencia sin servidor en Snowflake Cortex, el servicio totalmente gestionado de Snowflake que ofrece soluciones de machine learning e IA en Data Cloud. También estará disponible en Amazon Web Services (AWS), junto con otros archivos y catálogos de modelos, que incluirán Hugging Face, Lamini, Microsoft Azure, el catálogo de API de NVIDIA, Perplexity, Together AI, entre otros.

Arctic proporciona inteligencia de vanguardia con alta eficiencia de recursos

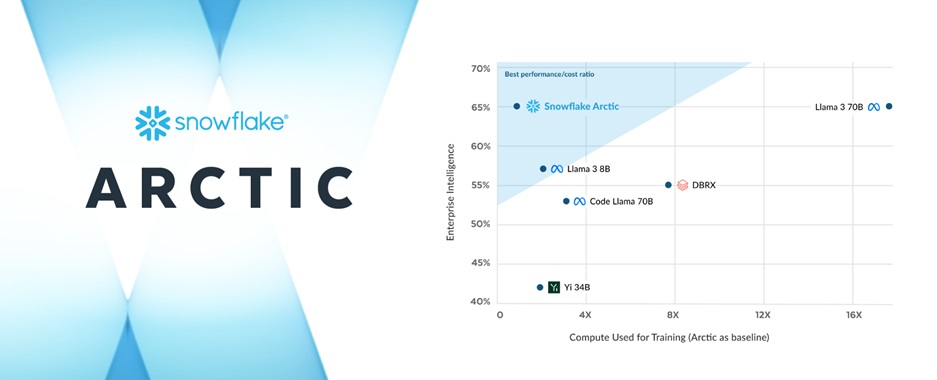

El equipo de investigación de IA de Snowflake, que está compuesto por una selección única de investigadores e ingenieros de sistemas líderes en el sector, tardó menos de tres meses y gastó aproximadamente una octava parte del coste de entrenamiento de modelos similares al construir Arctic. Entrenado utilizando instancias P5 de Amazon Elastic Compute Cloud (Amazon EC2), Snowflake está estableciendo un nuevo punto de referencia en cuanto a la rapidez con la que pueden entrenarse los modelos empresariales abiertos más avanzados, lo que en última instancia permitirá a los usuarios crear modelos personalizados rentables a gran escala.

Como parte de este esfuerzo estratégico, el diseño diferenciado del MoE de Arctic mejora tanto los sistemas de entrenamiento como el rendimiento de los modelos, con una composición de datos meticulosamente diseñada y centrada en las necesidades de la empresa. Arctic también ofrece resultados de alta calidad, activando 17 de los 480.000 millones de parámetros a la vez para lograr una calidad líder en el sector con una eficiencia simbólica sin precedentes. En un avance de eficiencia, Arctic activa aproximadamente un 50 por ciento menos de parámetros que DBRX, y un 75 por ciento menos que Llama 3 70B durante la inferencia o el entrenamiento. Además, supera a los principales modelos abiertos, como DBRX, Mixtral-8x7B y otros, en codificación (HumanEval+, MBPP+) y generación de SQL (Spider), al mismo tiempo que ofrece un rendimiento líder en comprensión general del lenguaje (MMLU).

Snowflake sigue acelerando la innovación en IA para todos los usuarios

Snowflake sigue proporcionando a las empresas los datos fundacionales y los bloques de construcción de IA de vanguardia que necesitan para crear potentes aplicaciones de IA y machine learning con sus datos empresariales. Cuando se acceda a Snowflake Cortex, Arctic acelerará la capacidad de los clientes para crear aplicaciones de IA de nivel de producción a escala, dentro del perímetro de seguridad y gobernanza del Data Cloud.

Además del Arctic LLM, la familia de modelos Snowflake Arctic también incluye el recientemente anunciado Arctic integrado, una familia de modelos de texto embebido de última generación disponible para la comunidad de código abierto bajo una licencia Apache 2.0. La familia de cinco modelos está disponible en Hugging Face para su uso inmediato y pronto estará disponible como parte de la función embebida de Snowflake Cortex (en vista previa privada). Estos modelos de integración están optimizados para ofrecer un rendimiento de recuperación líder con aproximadamente un tercio del tamaño de modelos comparables, lo que proporciona a las organizaciones una solución potente y rentable a la hora de combinar conjuntos de datos propios con LLM como parte de una generación aumentada por recuperación o un servicio de búsqueda semántica.

Snowflake también da prioridad a ofrecer a los clientes acceso a los LLM más nuevos y potentes del Data Cloud, incluidas las recientes incorporaciones de los modelos de Reka y Mistral AI. Además, Snowflake ha anunciado recientemente la ampliación de la asociación con NVIDIA para continuar su innovación en IA, uniendo la plataforma acelerada de NVIDIA full-stack con Data Cloud de Snowflake para ofrecer una combinación segura y excepcional de infraestructura y capacidades de computación para desbloquear la productividad de la IA. Snowflake Ventures también ha invertido recientemente en Landing AI, Mistral AI, Reka y otras empresas para impulsar el compromiso de Snowflake de ayudar a los clientes a crear valor a partir de sus datos empresariales con LLM e IA.