La computación cuántica lleva años prometiendo un salto cualitativo, pero sigue enfrentándose a una pregunta menos visible que la del rendimiento: dónde y cómo se integra en las infraestructuras reales que hoy sostienen el cómputo empresarial. En ese terreno, más operativo que teórico, se sitúa el nuevo acuerdo entre Qilimanjaro Quantum Tech y Oxigen Data Center, dos compañías con sede en Barcelona que han decidido abordar conjuntamente un problema que apenas empieza a formularse en el sector: la convivencia física, operativa y regulatoria entre sistemas cuánticos y centros de datos comerciales.

Qilimanjaro no es una recién llegada al debate. La compañía catalana abrió recientemente lo que define como el primer centro de datos multimodal que integra computación clásica con dos aproximaciones cuánticas distintas, digital y analógica. Ahora, con el respaldo de Oxigen Data Center, proveedor de colocation, nube privada e infraestructuras híbridas con capacidades de computación de alto rendimiento (HPC), el foco se desplaza del experimento controlado a un entorno más cercano a la explotación industrial.

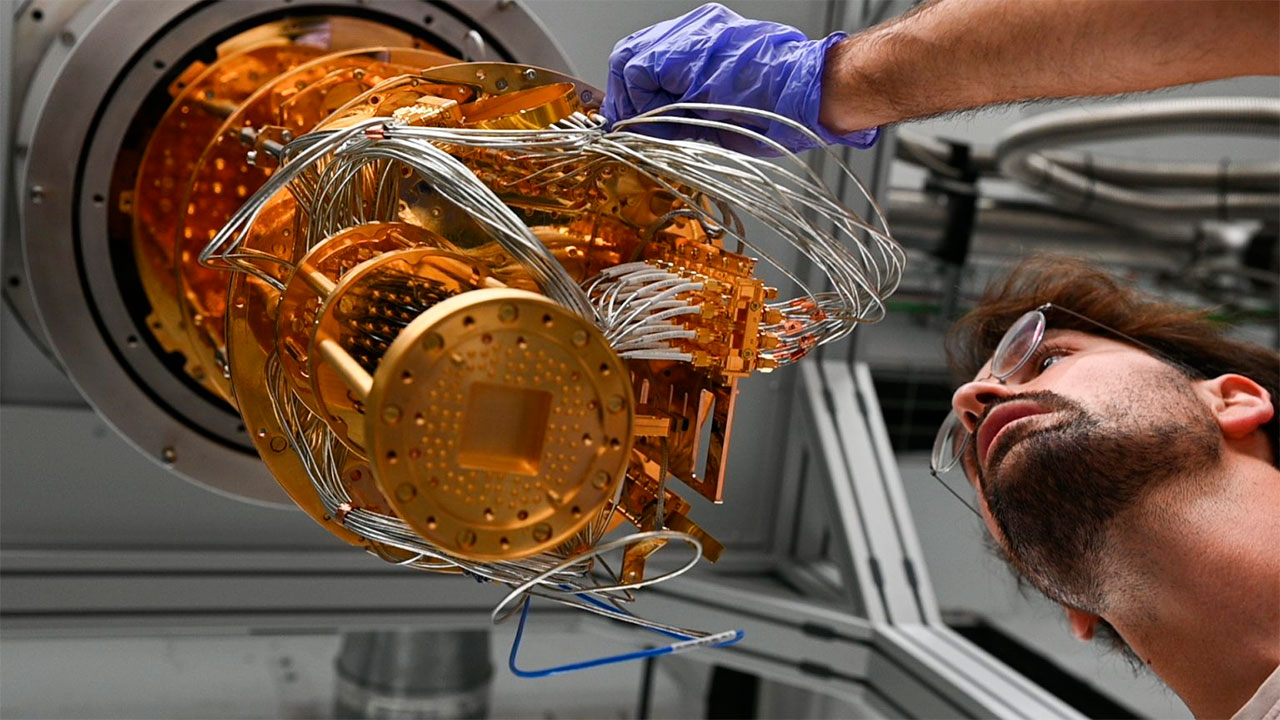

El acuerdo no persigue, al menos por ahora, el despliegue masivo de procesadores cuánticos en instalaciones comerciales. El objetivo declarado es más preliminar y, a la vez, más estructural: entender los requisitos mutuos que deben cumplirse para que estas tecnologías puedan operar juntas. Refrigeración, consumo energético, aislamiento, conectividad, estándares de operación, marcos regulatorios y modelos de acceso remoto aparecen como variables críticas en un ecosistema que todavía carece de referencias consolidadas.

El movimiento se produce en un momento en el que la computación cuántica sigue en fase de escalado, con avances desiguales entre plataformas y fabricantes. Los procesadores digitales, basados en qubits lógicos y puertas cuánticas, concentran buena parte de la atención mediática, pero arrastran desafíos persistentes en corrección de errores y estabilidad. Qilimanjaro ha optado por una vía complementaria: la computación cuántica analógica, apoyada en chips de fluxonios, que permite abordar ciertos problemas continuos y de optimización con menores exigencias de corrección.

Esta distinción técnica tiene consecuencias directas sobre la infraestructura. Los sistemas analógicos, al requerir menos capas de control lógico, presentan perfiles operativos distintos, tanto en términos de latencia como de consumo y complejidad. Integrarlos en un centro de datos comercial no plantea los mismos retos que los sistemas digitales, aunque introduce otros, menos explorados, relacionados con su calibración y uso específico.

Oxigen Data Center entra en la ecuación desde una perspectiva distinta. La compañía opera varias instalaciones Tier III en Cataluña y desarrolla un plan de expansión por la península ibérica y Europa. Su posicionamiento se apoya en la capacidad de absorber nuevas cargas de trabajo, desde inteligencia artificial hasta HPC, sin comprometer gobernanza del dato ni cumplimiento normativo. La computación cuántica, aún incipiente, se suma a esa lista de tecnologías emergentes que obligan a repensar la arquitectura tradicional del centro de datos.

El interés de Oxigen no se limita al hardware. Integrar sistemas cuánticos implica definir cómo se orquestan con recursos clásicos, cómo se exponen a los usuarios finales y bajo qué modelos de servicio. La promesa de una infraestructura híbrida accesible a sectores diversos, desde la industria hasta la investigación, depende tanto del software y de las interfaces como de la sala blanca que aloja los equipos.

En este punto aparece la noción de “quantum cloud”, un concepto todavía difuso que aspira a ofrecer acceso remoto a capacidades cuánticas sin exigir a los usuarios una comprensión profunda de la física subyacente. Qilimanjaro ya explora esta vía a través de su plataforma SpeQtrum QaaS, que combina recursos analógicos, digitales y clásicos. La colaboración con Oxigen busca trasladar ese enfoque a un entorno más cercano a los estándares comerciales del centro de datos.

Las declaraciones de los directivos refuerzan esta lectura. Marta P. Estarellas, consejera delegada de Qilimanjaro, insiste en que el futuro del cómputo será híbrido y que la definición de cómo se comunican procesadores cuánticos y máquinas clásicas no puede posponerse. Benjamín Rovira Guasch, CEO de Oxigen, apunta a la ventaja estratégica de anticipar la integración de estas tecnologías antes de que su demanda sea masiva.

Sin embargo, la iniciativa también pone de relieve una tensión habitual en el sector: la distancia entre la madurez tecnológica y la preparación industrial. Aunque los casos de uso en simulación molecular, optimización o entrenamiento de modelos de inteligencia artificial se citan con frecuencia, su traslado a entornos productivos sigue siendo limitado. La computación cuántica analógica ofrece ventajas inmediatas en ciertos dominios, pero su adopción depende de que existan infraestructuras capaces de soportarla de forma estable y repetible.

Desde una perspectiva europea, el acuerdo tiene una lectura adicional. La localización en Barcelona y la referencia explícita a una “nube cuántica desde Europa” conectan con las estrategias comunitarias de soberanía digital y reducción de dependencias tecnológicas. Frente a los grandes proveedores globales de nube, iniciativas como esta buscan construir capacidades propias, aunque todavía fragmentadas y en fase exploratoria.

El trabajo conjunto entre Qilimanjaro y Oxigen se plantea como un proceso de aprendizaje compartido. No se trata solo de adaptar los centros de datos a los requisitos cuánticos, sino también de ajustar los propios sistemas cuánticos a las restricciones operativas de infraestructuras comerciales, donde la fiabilidad, la seguridad y la eficiencia energética no son negociables.

Queda por ver hasta qué punto estas pruebas desembocarán en modelos replicables. La heterogeneidad de las tecnologías cuánticas y la falta de estándares consolidados complican la generalización. Aun así, el simple hecho de trasladar la conversación del laboratorio al centro de datos introduce una variable nueva en un sector acostumbrado a medir avances en número de qubits o tasas de error.

El acuerdo no resuelve, por ahora, las incógnitas sobre costes, escalabilidad económica o demanda real. Tampoco aclara cuándo la computación cuántica pasará de ser un recurso experimental a un componente habitual de la infraestructura digital. Lo que sí aporta es un marco para empezar a formular esas preguntas desde la práctica, no solo desde la teoría.

En ese sentido, la colaboración funciona como un indicio de hacia dónde se desplaza el debate. Menos énfasis en promesas abstractas y más atención a la integración, la operación diaria y la compatibilidad con sistemas existentes. Un enfoque que, pese a su discreción, puede resultar determinante cuando la computación cuántica deje de ser una excepción y empiece a reclamar un espacio estable en los centros de datos comerciales.