Fujitsu ha anunciado que ha sido incluida en la lista de «Empresas más admiradas del mundo» del 2022 de la revista FOFujitsu ha anunciado el desarrollo de un kit de herramientas de recursos que ofrece, a los desarrolladores, orientación para evaluar el impacto ético y los riesgos de los sistemas de IA basados en las directrices internacionales de ética de la IA. Fujitsu ofrecerá estos recursos de forma gratuita a partir del 21 de febrero de 2022 para promover el despliegue seguro de los sistemas de IA en la sociedad.

El kit de herramientas consiste en una variedad de estudios de casos y materiales de referencia, incluyendo un método recientemente desarrollado para aclarar los requisitos éticos en las directrices de ética de la IA escritas en lenguaje natural, así como para aplicar los requisitos éticos a los sistemas de IA reales. Los recursos en japonés pueden descargarse y en un futuro próximo estarán disponibles en inglés.

Con esta guía, Fujitsu pretende evitar malentendidos y riesgos potenciales causados por las diferencias en la interpretación de las descripciones de las directrices, ofreciendo a los desarrolladores y operadores de sistemas de IA nuevas herramientas para identificar y prevenir a fondo posibles problemas éticos en las primeras etapas del proceso de desarrollo, de acuerdo con las mejores prácticas internacionales.

De cara al futuro, Fujitsu trabajará activamente para asociarse con organismos gubernamentales, empresas privadas e investigadores de primera línea para seguir perfeccionando y promocionando su recién desarrollada metodología, y pretende publicar una versión ampliada del conjunto de recursos en el año fiscal 2022.

Antecedentes

En abril de 2021, la Comisión Europea publicó un borrador para un marco regulatorio que pedía una respuesta ética integral para los desarrolladores de sistemas de IA, los usuarios y las partes interesadas en respuesta a las crecientes preocupaciones que rodean el sesgo algorítmico y la toma de decisiones discriminatorias en las aplicaciones de IA y aprendizaje automático.

Para comprometerse plenamente con el uso responsable de la tecnología y ganarse la confianza de la sociedad en los sistemas de IA y en las empresas y organizaciones que participan en este espacio, Fujitsu ha formulado su propio Compromiso de IA en 2019, así como una nueva Oficina de Ética y Gobernanza de la IA para desarrollar y aplicar políticas sólidas para la ética de la IA, promover la gobernanza ética de la IA de la organización para garantizar su eficacia. Ahora, Fujitsu pasará de los principios a la práctica mediante la implementación constante de las mejores prácticas en el mundo real para garantizar la realización de tecnologías éticas, seguras y transparentes de IA y aprendizaje automático.

En la actualidad, es una práctica común en el desarrollo de sistemas de IA identificar los posibles riesgos éticos en los sistemas de IA basándose en las directrices de ética de la IA emitidas por las autoridades gubernamentales y las empresas. Sin embargo, estas directrices están escritas en un lenguaje natural, lo que contribuye a posibles diferencias de interpretación y malentendidos entre diseñadores y desarrolladores que pueden llevar a medidas inadecuadas o insuficientes. Con este método también es difícil juzgar si el contenido de las directrices ha sido revisado de forma exhaustiva y adecuada.

No obstante, siguen existiendo muchos problemas y la posible mala interpretación de las directrices en la fase de diseño de las nuevas tecnologías puede dar lugar a medidas insuficientes o inadecuadas para contrarrestar el riesgo.

Nuevo método de evaluación y recursos para ayudar a clarificar las directrices y el riesgo ético

Al preparar este nuevo conjunto de herramientas y orientaciones para los desarrolladores, Fujitsu realizó análisis de incidentes anteriores relacionados con la IA recogidos en la base de datos de incidentes de IA del consorcio internacional Partnership on AI . Este proceso llevó a la conclusión de que las cuestiones éticas relacionadas con los sistemas de IA pueden contextualizarse con el intercambio de información («interacciones») entre elementos discretos dentro de un sistema de IA y entre un sistema de IA y sus usuarios y otras partes interesadas.

Sobre la base de estos resultados, Fujitsu ha desarrollado con éxito un método de evaluación para identificar sistemáticamente las cuestiones éticas relevantes relacionadas con los sistemas de IA, lo que permite la creación de modelos de ética de la IA capaces de aclarar la interpretación de las directrices éticas de la IA.

Fujitsu aplicó su nuevo método de evaluación a 15 casos representativos de la Base de Datos de Incidentes de IA (164 casos globales registrados hasta el 21 de febrero de 2022, los ejemplos incluían casos de áreas como el sector financiero y de recursos humanos). Aplicando el nuevo método, todos los problemas éticos que se produjeron en casos de uso del mundo real se identificaron con éxito como riesgos por adelantado durante las pruebas de verificación, cuyos resultados se han publicado.

Fujitsu ofrecerá el siguiente conjunto de recursos, que consiste en una serie de recursos y orientaciones para que los desarrolladores puedan consultarlos en su propio trabajo:

1. Whitepaper: Una visión general de la metodología

2. Manual del procedimiento de evaluación del impacto ético de la IA: Diagrama del sistema de IA, procedimiento de preparación del modelo ético de IA y explicación del método de correspondencia de problemas

3. Modelo ético de IA: Un modelo ético de IA basado en las directrices éticas de IA publicadas por la Comisión Europea (creado por Fujitsu).

4. Estudios de casos de análisis de ética de la IA: Resultados del análisis de los principales problemas éticos de la IA a partir de la base de datos de incidentes de la Asociación sobre la IA (hasta el 21 de febrero, había seis casos, que se añadieron secuencialmente).

Caso de uso: riesgo en el uso de la IA para la evaluación de individuos para préstamos bancarios, contratación de personal

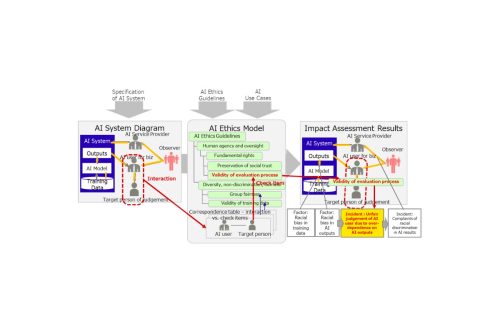

La figura 1 muestra un ejemplo de proceso de evaluación de un individuo típico en escenarios de casos de uso como la contratación de personal o la aprobación de préstamos bancarios. La tabla de correspondencias del modelo de ética de la IA identificó la «validez del proceso de evaluación» (si la evaluación se realiza de forma responsable con referencia a los resultados de salida del sistema de IA) como elemento de comprobación de la interacción (relación) entre el usuario del sistema de IA y la persona objeto de la evaluación, mientras que la «dependencia excesiva de los resultados de la IA», la «interpretación y evaluación selectiva de los resultados de salida» y el «desconocimiento de los resultados de salida» figuran como posibles riesgos.

En este ejemplo, los desarrolladores de sistemas de IA pueden identificar el riesgo de una «dependencia excesiva de los usuarios de los resultados de un sistema de IA que puede contener sesgos y llevar a decisiones injustas» como un posible riesgo en un sistema de IA y ajustar adecuadamente el sistema para prevenir este riesgo.

Figura 1. Esquema de la evaluación del impacto ético de la IA