La adopción de inteligencia artificial (IA) continúa su expansión entre las organizaciones de todo el mundo, impulsada especialmente por el auge de la IA generativa. Sin embargo, un nuevo estudio global revela que este avance tecnológico no va acompañado de una inversión proporcional en prácticas responsables. Según el informe IDC Data and AI Impact Report: The Trust Imperative, elaborado por IDC y encargado por SAS, únicamente el 40% de las empresas están aplicando mecanismos que garanticen la confiabilidad de sus sistemas de IA, como la gobernanza, la explicabilidad y las medidas de protección éticas.

La IA generativa, la más confiable… según la percepción

La encuesta, realizada a 2.375 profesionales del ámbito tecnológico y empresarial en Norteamérica, Latinoamérica, Europa, Oriente Medio, África y Asia-Pacífico, muestra una percepción creciente de confianza en la IA generativa. El 48% de los encuestados afirma tener plena confianza en esta modalidad, mientras que solo el 18% dice lo mismo sobre la IA tradicional, como los sistemas de aprendizaje automático.

A pesar de su reciente incorporación en muchos entornos corporativos, la IA generativa (incluyendo modelos como ChatGPT) supera en nivel de confianza a tecnologías más consolidadas, lo que plantea interrogantes sobre la base de dicha percepción. “Nuestra investigación muestra una contradicción: las formas de IA con interacción humana y familiaridad social generan mayor confianza, independientemente de su fiabilidad o precisión real”, explica Kathy Lange, directora de investigación en IA y Automatización en IDC.

El informe destaca que incluso en organizaciones con escasa inversión en medidas responsables, la IA generativa es percibida como hasta un 200% más confiable que la IA tradicional, a pesar de que esta última ofrece mayor estabilidad y explicabilidad técnica.

Priorizar la IA confiable impacta en el retorno de la inversión

Uno de los datos más relevantes del estudio es la relación directa entre las prácticas de IA responsable y los resultados financieros. Las organizaciones que han apostado por marcos de gobernanza, transparencia y uso ético en sus proyectos de IA tienen un 60% más de probabilidades de duplicar el retorno de la inversión (ROI) frente a aquellas que no lo han hecho.

No obstante, el desarrollo de políticas estructuradas de IA responsable no figura entre las principales prioridades estratégicas de la mayoría de las empresas analizadas. Solo un 2% incluye el desarrollo de un marco de gobernanza de IA entre sus principales iniciativas y menos del 10% ha implementado una política formal en este sentido.

Brechas críticas en gobernanza de datos y competencias internas

Además de la falta de salvaguardas éticas, el estudio identifica tres factores técnicos que dificultan la implementación efectiva de sistemas de IA: infraestructuras de datos inadecuadas, deficiencias en la gobernanza de datos y escasez de personal cualificado. Cerca del 49% de las organizaciones señala como obstáculo principal la existencia de entornos de datos fragmentados o no optimizados para la nube. Por su parte, el 44% apunta a procesos insuficientes de gobernanza de datos, y el 41% menciona la falta de perfiles con formación específica en IA.

En cuanto a los retos operativos, el acceso a fuentes de datos relevantes es considerado el mayor problema por el 58% de los participantes. Le siguen las preocupaciones por la privacidad y el cumplimiento normativo (49%) y la calidad de los datos utilizados (46%).

Confianza sin fundamento técnico

El desajuste entre percepción y realidad se extiende también a las cifras globales: el 78% de las empresas encuestadas afirma confiar plenamente en la IA, pero menos de la mitad ha adoptado medidas concretas para garantizar su confiabilidad técnica. Este contraste apunta, según los analistas de IDC, a un problema estructural en la forma en que las organizaciones evalúan y gestionan los riesgos asociados a esta tecnología.

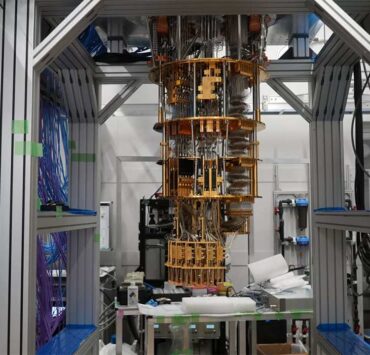

La IA cuántica, aún en fase incipiente de desarrollo, también aparece como una de las tecnologías emergentes que despierta una confianza creciente. El 26% de los encuestados declara tener plena confianza en ella, a pesar de que sus aplicaciones prácticas todavía están en fases tempranas.

Liderazgo en IA confiable: beneficios diferenciados

IDC distingue entre líderes y seguidores en cuanto a adopción de prácticas de IA confiable. Los líderes, que han invertido de forma significativa en marcos técnicos y éticos, tienen 1,6 veces más probabilidades de duplicar el ROI de sus proyectos de IA. Estos datos subrayan la relación entre el éxito empresarial y la implementación de salvaguardas técnicas, jurídicas y éticas en los sistemas de inteligencia artificial.

Bryan Harris, CTO de SAS, subraya la importancia de abordar esta cuestión desde una perspectiva amplia: “Por el bien de la sociedad, las organizaciones y los empleados, la confianza en la IA es imprescindible. Para lograrlo, la industria debe aumentar la tasa de éxito de las implementaciones, las personas deben revisar con espíritu crítico los resultados de la IA y los líderes deben capacitar a la plantilla para trabajar con esta tecnología”.

Retos para las estrategias de datos en IA

El estudio también destaca que, a medida que la IA se integra más profundamente en procesos críticos de negocio, la calidad y gobernanza de los datos adquieren un papel determinante. Las organizaciones que disponen de datos ricos, diversos y correctamente gestionados tienen más capacidad para maximizar beneficios y reducir los riesgos operativos o reputacionales vinculados a la IA.

No obstante, los datos recopilados revelan que muchas organizaciones aún no han desarrollado la infraestructura necesaria para sostener este tipo de estrategias. Las limitaciones en el acceso a datos adecuados, la falta de cumplimiento normativo y la ausencia de perfiles especializados están condicionando tanto la escalabilidad como la sostenibilidad de los proyectos de IA.

Marco de gobernanza, un pendiente común

El informe apunta a la ausencia de un marco común de gobernanza como uno de los factores más repetidos en las organizaciones analizadas. La mayoría no cuenta con políticas consolidadas que regulen el uso responsable de la IA, lo que aumenta la exposición a riesgos como sesgos algorítmicos, malinterpretaciones de los resultados o vulnerabilidades en la seguridad.

Esta situación contrasta con la creciente presencia de la IA en sectores sensibles, como servicios financieros, salud, educación o administración pública, donde los requisitos de explicabilidad, trazabilidad y cumplimiento son cada vez más estrictos. La falta de medidas claras puede limitar tanto la adopción efectiva de IA como la confianza de los usuarios finales.