La IA Explicable representa un área de creciente interés en el campo de la inteligencia artificial y el aprendizaje automático. Aunque las tecnologías de IA pueden tomar decisiones automáticamente a partir de los datos, la «IA Explicable» también proporciona razones individuales para estas decisiones, lo que ayuda a evitar el llamado fenómeno de la «caja negra», en el que la IA llega a conclusiones a través de medios poco claros y potencialmente problemáticos. Aunque ciertas técnicas también pueden proporcionar hipotéticas mejoras que se podrían obtener cuando se produce un resultado no deseable, éstas no proporcionan ningún paso concreto para mejorar.

Por ejemplo, si una IA que emite juicios sobre el estado de salud de una persona y determina que no es saludable, la nueva tecnología puede aplicarse para explicar primero la razón del resultado a partir de datos de exámenes médicos como la altura, el peso y la presión arterial. A continuación, puede ofrecer además al usuario sugerencias específicas sobre la mejor manera de recuperar la salud, identificando la interacción entre un gran número de complicados elementos de los exámenes médicos y a partir de datos anteriores, mostrando pasos específicos para conseguir mejorar, teniendo en cuenta la viabilidad y la dificultad de la implementación.

Esta nueva tecnología ofrece la posibilidad de mejorar la transparencia y la fiabilidad de las decisiones tomadas por la Inteligencia Artificial, lo que permitirá a más personas en el futuro interactuar con las tecnologías que la utilizan, ofreciendo una sensación de confianza y tranquilidad.

Antecedentes del desarrollo

En la actualidad, las tecnologías de aprendizaje profundo ampliamente utilizadas en los sistemas de IA que requieren tareas avanzadas, como el reconocimiento facial o la conducción automática, toman automáticamente diversas decisiones basadas en una gran cantidad de datos utilizando una especie de modelo predictivo de “caja negra”. Sin embargo, en el futuro se debe garantizar la transparencia y la fiabilidad de los sistemas de Inteligencia Artificial y esto, se convertirá en una cuestión importante para que la IA realice propuestas fundamentales para la sociedad. Esta necesidad ha hecho que aumente el interés y la investigación en tecnologías de «IA Explicable».

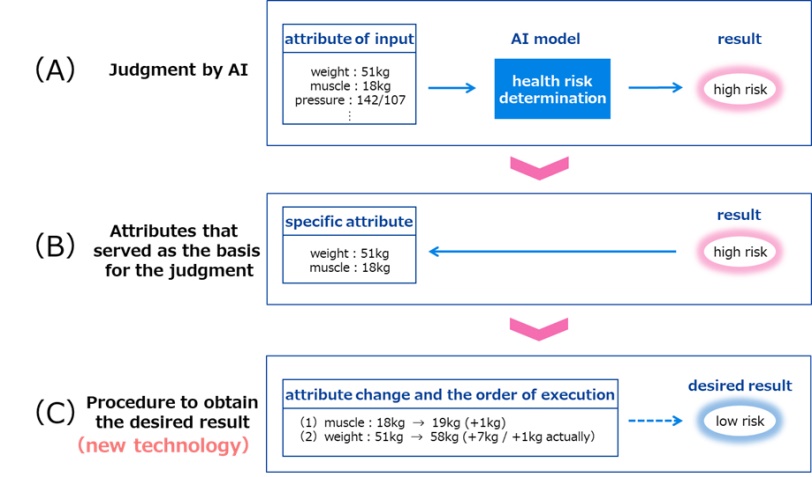

Por ejemplo, en las revisiones médicas, la IA puede determinar con éxito el nivel de riesgo de una enfermedad basándose en datos como el peso y la masa muscular (Figura 1 (A)). Además de los resultados del juicio sobre el nivel de riesgo, la atención se ha centrado cada vez más en la «IA explicable» que presenta los atributos (Figura 1 (B)) que sirvieron de base para el juicio.

Dado que la Inteligencia Artificial determina que los riesgos para la salud son elevados basándose en los atributos de los datos de entrada, es posible cambiar los valores de estos atributos, para obtener los resultados deseados con bajos riesgos para la salud.

Fig.1 Juicio y explicación de la IA

Para conseguir los resultados deseados en las decisiones automatizadas de la IA, es necesario, no sólo presentar los atributos que hay que cambiar, sino también los que se pueden cambiar con el menor esfuerzo posible.

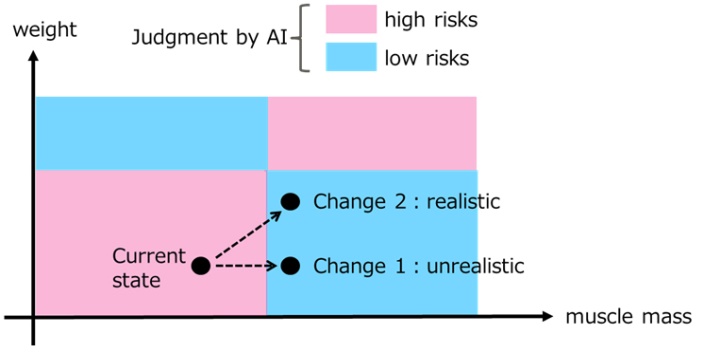

En el caso de los chequeos médicos, si se quiere cambiar el resultado de la decisión de la IA de un estado de alto riesgo a uno de bajo, conseguirlo con menos esfuerzo puede parecer aumentar la masa muscular (Figura 2 Cambio 1), pero no es realista aumentar sólo la masa muscular, sin cambiar el peso, por lo que incrementar el peso y la masa muscular simultáneamente es una solución más realista (Figura 2 Cambio 2). Además, hay muchas interacciones entre atributos como el peso y la masa muscular, como las relaciones causales en las que el peso aumenta con el crecimiento muscular, y el esfuerzo total necesario para realizar los cambios depende del orden en el que se cambian los atributos. Por lo tanto, es necesario presentar el orden adecuado en el que se cambian los atributos. En la Figura 2, no es obvio si hay que modificar primero el peso o la masa muscular para llegar al Cambio 2 desde el estado actual, por lo que sigue siendo un reto encontrar un método apropiado teniendo en cuenta la posibilidad y el orden de los cambios entre un gran número de candidatos potenciales.

Fig.2 Cambios en los atributos

Acerca de la nueva tecnología desarrollada

A través de la investigación conjunta sobre el aprendizaje automático y data mining, Fujitsu Laboratories y el Laboratorio Arimura de la Escuela de Postgrado de Ciencia y Tecnología de la Información de la Universidad de Hokkaido, han desarrollado nuevas tecnologías de IA que pueden explicar a los usuarios las razones de las decisiones de la IA, lo que permite descubrir conocimientos útiles y procesables.

Las tecnologías de IA como LIME y SHAP, que se han desarrollado como tecnologías de IA para apoyar la toma de decisiones de los usuarios, hacen que la decisión sea convincente al explicar por qué la IA la tomó. La nueva tecnología desarrollada conjuntamente se basa en el concepto de explicación contrafactual y presenta la acción en el cambio de atributos y el orden de ejecución como un procedimiento. A la vez que evita cambios irreales mediante el análisis de casos anteriores, la IA estima los efectos de los cambios de valores de atributos en otros valores, como la causalidad, y calcula la cantidad que el usuario tiene que cambiar realmente en función de ello, lo que permite presentar las acciones que lograrán resultados óptimos en el orden adecuado y con el menor esfuerzo.

Por ejemplo, si uno tiene que añadir 1 kg de masa muscular y 7 kg a su peso corporal para reducir el riesgo en el atributo de entrada y su orden (Figura 1 (C)) que cambia para obtener el resultado deseado en un chequeo médico, es posible estimar la relación analizando la interacción entre la masa muscular y el peso corporal por adelantado. Esto significa que si se añade 1 kg de masa muscular, el peso corporal aumentará en 6 kg. En este caso, de los 7 kg adicionales necesarios para el aumento de peso, la cantidad requerida de masa muscular es de sólo 1 kg. En otras palabras, la cantidad de cambio que uno tiene que hacer en realidad es añadir 1 kg de masa muscular y 1 kg de peso, por lo que uno puede obtener el resultado deseado con menos esfuerzo frente a cambiar su peso primero.